導讀:攝像頭在智能汽車時代被譽為“汽車之眼”,如果沒有記錯的話是Mobileye開創了智能汽車基于AI底層的攝像頭的應用,而馬斯克的特斯拉徹底把他發揚光大了,這下汽車產業一發不可收拾的開啟了基于AI的攝像頭的競賽。

上篇文章《深入了解當前主流L2的ADAS 模塊(零件以及供應鏈)》了解到智能汽車市場的攝像頭市場巨大,那么智能汽車單車到底要用多少個呢?他們分別用在哪方面呢?智能汽車攝像頭技術和難點在哪里?

所以本文借用相關資料希望從以下幾個方面,希望能給大家帶來一些觀點和思考。

(1)智能汽車單車到底要用多少個攝像頭?

(2)智能汽車攝像頭分別用在哪方面呢?

(3)智能汽車攝像頭技術原理是什么?

(4)智能汽車攝像頭應用的難點在哪里?

一、智能汽車到底要用多少攝像頭?

當前L2++的智能駕駛攝像頭大概都在8-15個覆蓋整車的360度視覺,以及觸及艙內乘員監控。

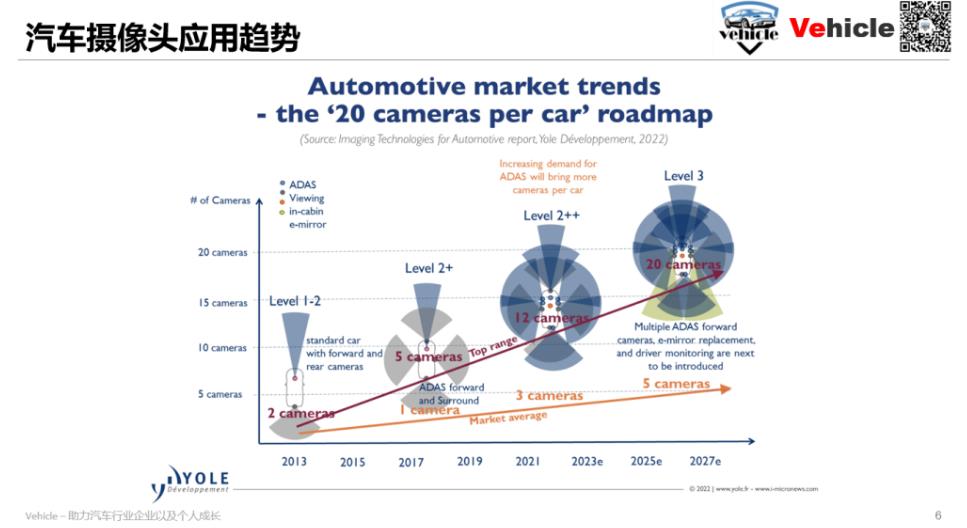

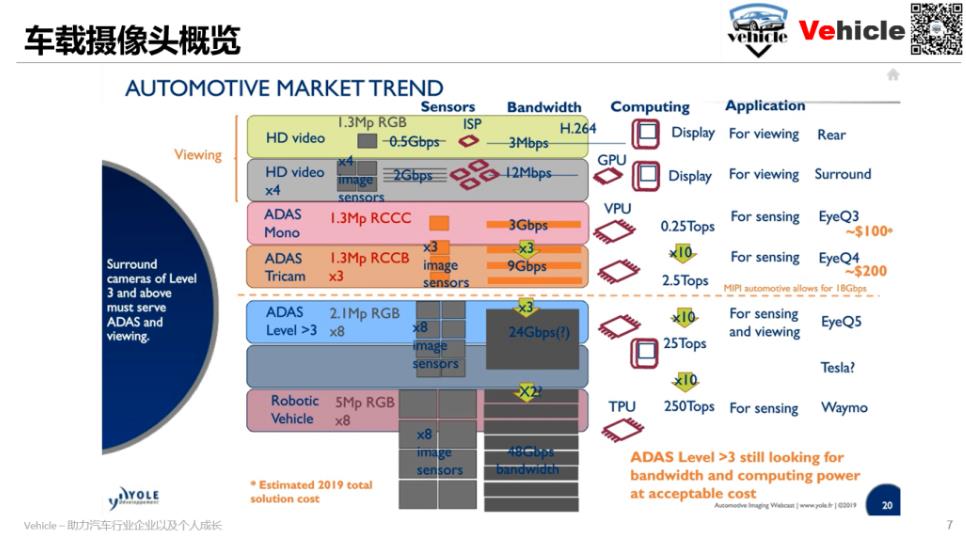

根據yole的的數據表明:

在L1-2階段攝像頭大概1-2個;

到了L2階段攝像頭大概是1-5個;

到了L2++階段也就是現在攝像頭大概3-12個;

到了L3階段大概5-20個;

所以Yole的數據比較真實,未來單車的攝像頭數據都是十幾個。這個在手機消費電子行業任憑你浴霸甚至整個手機都放攝像頭也比不了。

二、智能汽車攝像頭都用在什么地方?

那么智能汽車,他的攝像頭都用在哪里?起到什么作用?

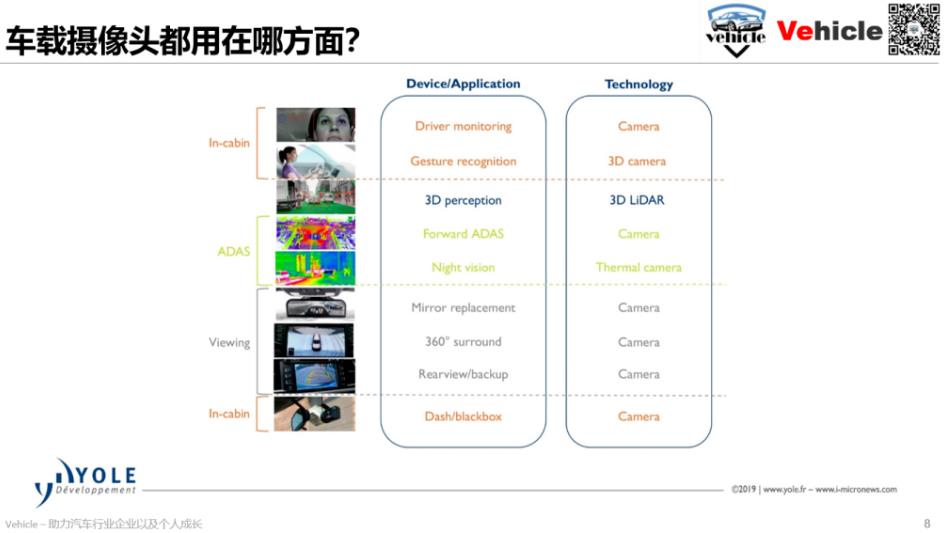

如上圖Yelo的圖片,車載攝像頭大概會用在如下四個方面,其實總結是三個方面:

(1)智能駕駛環境感知 - 他包含兩個部分得攝像頭,一部分是環境感知攝像頭,也就是之前文章講得絕大部分;另外一部分是熱成像攝像頭用于夜視。

(2)環境探測視覺呈現 - 他包括三部分分別是 內部后視鏡的替換,360度視野,一般360視野包含了倒車視野攝像頭,最后一個是行車記錄儀或者行車黑盒子,他與智能駕駛環境感知的差異是,環境感知是給機器看的,視覺呈現是給人看的,所以他們的技術特征不一樣,下文會講到。

(3)駕駛艙監控 - 他包括駕駛員監控識別攝像頭和3D手勢識別攝像頭,也屬于輸入給機器的數據。

三、智能汽車攝像頭技術原理?

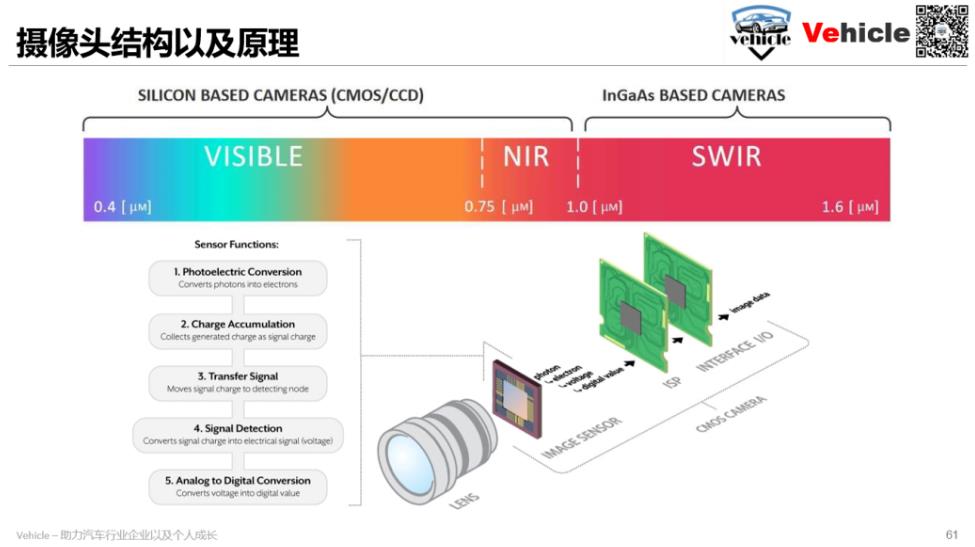

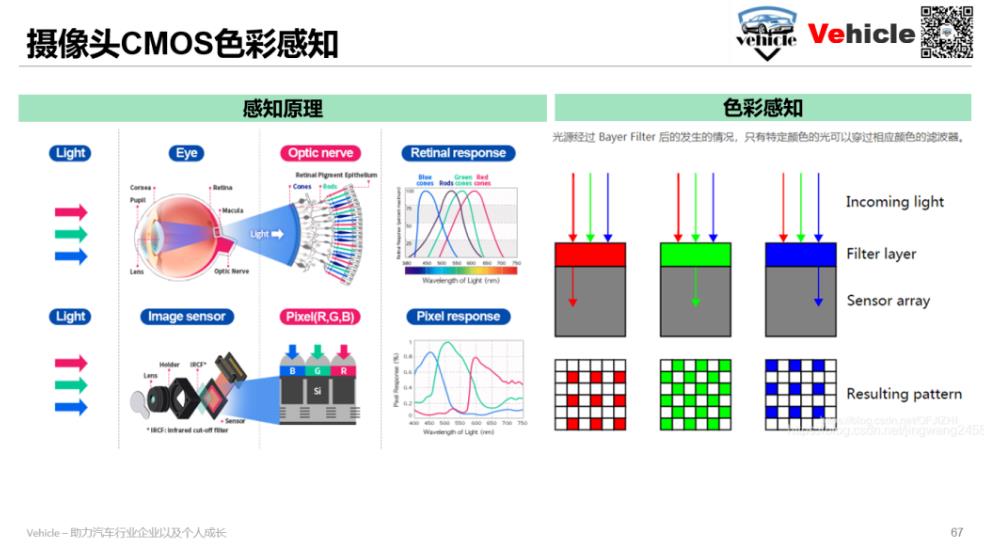

人之所以看世界是五彩斑斕的,是因為人看到的全是來自外界物體的反射光。攝像頭的基本原理是類似于眼鏡通過傳感器接收來自于物體反射的光線。光線有人類看的見的可見光,也有人類看不見的NIR 近波紅外線,SWIR短波紅外線,而傳感器可以識別也就形成了各種夜視視像頭。

當前攝像頭傳感器主要有CMOS 和CCD, CCD 相對于 CMOS 的優勢在于其高感光度,高像素,高功耗為代價獲得更好的圖像質量,所以一般用在單反相機,而高功耗會導致熱量問題和更高的價格,另外CMOS讀取速度快,成本低所以當前車載攝像頭都采用CMOS。另外還有夜視 (NV) 或高動態范圍 (HDR) 等對光高度敏感的專用芯片。

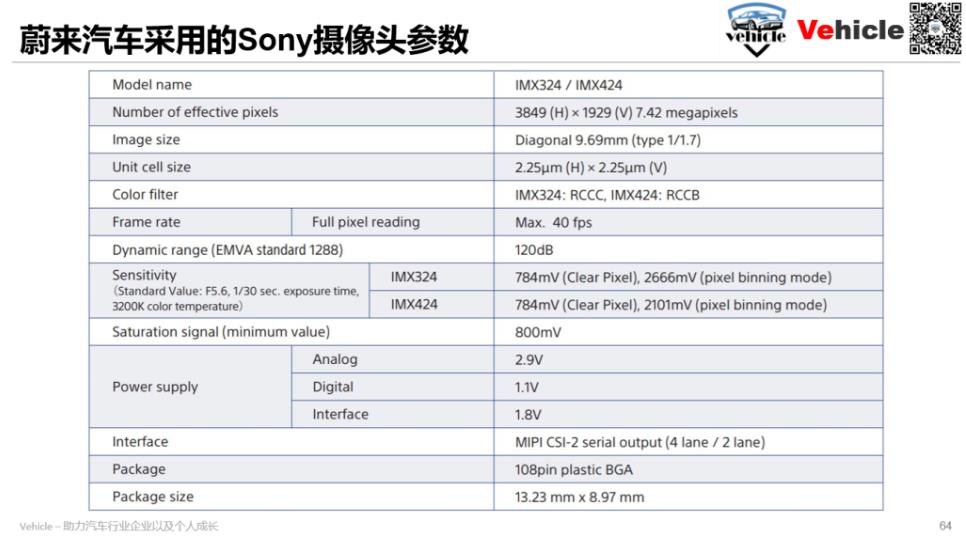

一般去選擇或者判斷攝像頭,都會考慮攝像頭的參數和配置,上圖為Sony車載攝像頭的參數,應該是蔚來汽車要采用的8Mp攝像頭參數配置,上圖中參數拋開由鏡頭決定的視場角(FOV)和電源信息,車載傳感器一般會有以下這些指標:

像素(megaPixels):像素可以決定看的多遠多大,但對于AI 那么處理器需要信息越多。

幀數(fps),每秒獲取畫幅,這個汽車上體現的就是例如碰撞時間。

Dynamic range:測量了圖像傳感器在同一張照片中同時捕獲光明和黑暗物體的能力也即動態范圍越大,保留的高光區和陰影區信息越多。

如特斯拉的前視 1.2 Mp 1280x964 30fps ,就可以去解讀了,但在智能駕駛領域。其實攝像頭還根據可以感知顏色來分類,他主要是原因是CMOS 是一種光電傳感器只能感應光的強度,不能區分光的波長(色彩),因此圖像傳感器需要通過色彩濾波(Color Filter)以獲取像素點的色彩信息。色彩濾波陣列,英文名 Color Filter Array 或 Color Filter Mosaic ,簡稱 CFA 或 CFM,是像素傳感器上方的一層馬賽克覆層,用于采集圖像的色彩信息。一般的光電傳感器只能感應光的強度,不能區分光的波長(色彩),因此圖像傳感器需要通過色彩濾波(Color Filter)以獲取像素點的色彩信息,。

生活中通常所用的攝像頭都是通過以下濾波(R = Red 紅色;C= Clear 不濾光;B=Blue ;G=Green 藍色)獲取顏色的。每個像素只能感應一種顏色的光,但是我對外輸出的時候,需要知道這個像素的RGB值,我就只能通過周圍像素去計算,這個計算和轉換是靠ISP去完成的。進從而得出我這個像素的RGB的值,這樣我每個像素雖然只感應了一種光,但是每個像素經過處理后傳輸到外面后就是有RGB的信息了。

當前車載攝像頭CMOS 感知色彩有以下幾種:

RGGB也常縮寫成RGB,RGB是三原色,世間萬物的色彩鼻祖,所以這種攝像頭是生活常用的,也是視覺呈現常用的。例如360環視。

RCCC 最大限度提高光靈敏度,保留紅色例如紅綠燈和尾燈。RCCC 圖像看起來是單色的,無法記錄彩色圖像。三個透明濾光片為其提供最佳靈敏度,而紅色濾光片元件可識別來自剎車或交通信號燈的紅光。所以當前大部分ADAS前置攝像頭采用這個方案包括特斯拉HW2.0。

RCCB 提高了光靈敏度和更少的噪點,帶有一個紅色濾光片、兩個透明濾光片和一個藍色濾光片(見圖 2c)。但它分辨色彩的能力更好,采集的圖像既可以用于機器分析,也可以用于人眼觀察。所以當前不少采用RCCB既保證光靈敏也保障了視覺屏幕輸出的需求,例如特斯拉的HW2.5之后的攝像頭以及蔚來ET5,ET7采用的索尼攝像頭IMX424。

根據Yole發布的信息,對于參數和環境感知的色彩都影響攝像頭的數據量,從而影響數據的傳輸以及數據處理器的算力。

四、智能汽車攝像頭應用難點?

寫到這里發現一個很有意思的現象,歐美朝著L4,L5自動駕駛進軍Robotaix的 Curise(了解Curise 點擊Cruise以及其自動駕駛技術), Waymo都采用RGB的攝像頭,我粗略的查詢了下中國Robtaix的文行知遠,Didi都采用RGB的攝像頭(這個信息沒有確認,如有知道的還請探討)所以對于未來L4-L5的真正全自動駕駛他的感知應該是通過RGB豐富感知環境再通過類似于激光雷達的傳感器融合實現。

如果以上推測成立,那么可以推測以下兩個結論:

(1)當前特斯拉的自動駕駛天花板在感知傳感器攝像頭方面,再牛逼的算法也無力回天畢竟你對環境感知缺少三原色中的一種。當然有人透露tesla下一代攝像頭將采用SONY 5mp的RGGB攝像頭。

(2)蔚來汽車最新的Aquila攝像頭方案不經濟而且精確比不了同樣采用激光雷達加RGB攝像頭。

有大牛表示,目前國內大部分新勢力都是“沿用”特斯拉的方案采用RCCC或者RCCB,可能就是跟著跑。以上推測為亂猜測,拋磚引玉,希望真的懂得大牛留言指導討論,以方便大家都增強或者更正認知!當然智能汽車也只是產業化的產物,所以在攝像頭甚至其他傳感器得應用其實都在在檢測精度、計算處理需求、功率和成本限制、魯棒性和可靠性,拓展延續性等實際參數之間選擇和調和,所以他準確得說是一門“藝術”而不是“科學”,所以他的難點是基于自身產品定位以及發展,服務客戶也滿足發展等矛盾的調和和選擇最優解。而不是簡單的從參數和數量上去論英雄。

參考文章:

1. Paving the way to self-driving cars with advanced driver assistance systems - TI

2. ADAS High Bandwidth Imaging Implementation Strategies - TI

3. Advanced Driver Assistance (ADAS) Solutions Guide - TI

4. The Fundamentals of Camera and Image Sensor Technology - Jon Chouinard

5. Computer Vision in Automated Parking Systems: Design, Implementation and Challenges - Markus Heimbergera , Jonathan Horganb , Ciaran Hughesb , John McDonaldb , Senthil Yogamanib,?

6. Seeing Through Fog Without Seeing Fog: Deep Multimodal Sensor Fusion in Unseen Adverse Weather - Mario Bijelic1,3 Tobias Gruber1,3 Fahim Mannan2 Florian Kraus1,3 Werner Ritter1 Klaus Dietmayer3 Felix Heide2,4 1Mercedes-Benz AG 2Algolux 3Ulm University 4Princeton University

7. Sensor and Sensor Fusion Technology in Autonomous Vehicles: A Review -De Jong Yeong 1,2,3,* , Gustavo Velasco-Hernandez 1,2,3 , John Barry 1,2,3 and Joseph Walsh 1,2,3

8. On the Performance of One-Stage and Two-Stage Object Detectors in Autonomous Vehicles Using Camera Data - Manuel Carranza-García * , Jesús Torres-Mateo , Pedro Lara-Benítez and Jorge García-Gutiérrez

9. ADAS: Key Trends on ‘Perception’ - Junko yoshida

10. Challenges of full autonomy for sensing in autonomous vehicles - jeff hecht

11. Yole 圖片整理 - yole

12. CMOS圖像傳感器基礎知識和參數理解 - 成都子程電子

作者:Vehicle Pirate Jack